A evolução dos departamentos de TI

por

Manuel Jorge Brandão Estêvão de Araújo

Departamento de Engenharia Informática

Universidade de Coimbra

3030 Coimbra, Portugal

Resumo

Ao longo das últimas 6 décadas a tecnologia evoluiu para algo muito para além do que era imaginado a início. Os computadores passaram de máquinas gigantescas apenas ao alcance de algumas empresas para algo que qualquer um pode ter em casa.

Os departamentos de tecnologias da informação foram acompanhando esses e outros desenvolvimentos, adaptando-se e evoluindo a maneira como as empresas encaravam a tecnologia. A sua estrutura começou por ser composta por profissionais da área, com competências técnicas de um especificidade que hoje não é de todo requerida, passando ao longo do tempo a ser organizada em torno do negócio. Por outro lado, a dependência das tecnologias da informação foi crescendo nas empresas, não podendo estas dispensar nos dias de hoje os serviços de estruturas de apoio ao negócio como são estes departamentos.

Palavras chave: Evolução, departamentos de TI, tecnologia, sistemas de informação

Introdução

Os departamentos de tecnologias da informação (TI) variaram bastante de dimensão, tarefas e importância ao longo dos últimos 50 anos. Foram grandes os suficiente para albergar um computador que pesava toneladas, sítios fechados ao resto da organização donde entravam e saíam papeis, secundários ao ponto de as empresas funcionarem sem necessidade de um ou de o presidente da IBM dizer nos anos 40 que não havia mercado em todo o mundo para mais que 5 computadores. Agora podem variar de dimensão consoante a necessidade, prestam uma infinidade de serviços à empresa, são em muitos casos vitais para o funcionamento e criação de valor destas e há milhões de máquinas espalhadas pelo mundo, das mais variadas formas e feitios.

O artigo tem como objectivo mostrar a evolução das tarefas, da estrutura e da posição dos departamentos de TI no seio das empresas ao longo do tempo. Para tal é feita uma pequena análise da evolução dos computadores e da sua utilização, para depois passar a uma análise ao funcionamento e à organização dos departamentos dos anos 50 aos 60, dos 70 aos 80 e dos anos 90 ao presente. Para o final, o artigo fala das tendências para o futuro.

A evolução dos computadores

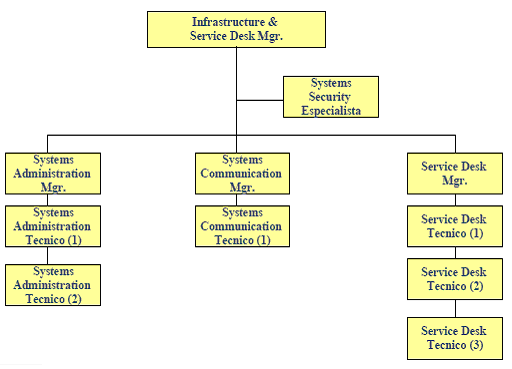

A evolução dos departamentos de TI está intrinsecamente ligada à evolução dos computadores e da tecnologia que os rodeia. Esta história começa com o aparecimento de máquinas de calcular gigantescas nos anos 40, tais como o ENIAC, que ocupavam salas inteiras, pesavam toneladas e consumiam mais de 100 kW de energia [5]. Estes computadores eram utilizados principalmente para fins militares.

Figura 1 - ENIAC (fonte: Wikipedia)

À medida que os anos iam passando e com o aparecimento dos transístores nos anos 50 (que foram lentamente substituindo as válvulas dos computadores mais antigos) e dos circuitos integrados (meados dos anos 60), os computadores iam ficando mais pequenos, mais baratos (quer em custo de aquisição, quer em manutenção, apesar de continuarem a ser muito caros) e mais rápidos. Nos anos 50 – o primeiro computador comercial surgiu em 1951 – e 60 o seu uso diversificou-se e começaram a aparecer novas aplicações para estas máquinas, tais como contabilidade e inventariado. O aparecimento de linguagens de programação mais “generalistas” como o COBOL e o BASIC ajudou nesta diversificação [4].

Nesta altura surgem também computadores mais pequenos, ou minicomputadores, máquinas cujo tamanho fica entre os mainframes que ocupam uma ou várias salas e os computadores pessoais, comparáveis às workstations de hoje.

Os anos 70 são uma altura em que a evolução se dá em passos bastante largos. Em 1971 surge o primeiro microprocessador, o Intel 4004. A partir daqui os computadores diminuem de tamanho ao ponto de caberem em cima de uma mesa e é então que surgem os microcomputadores e os terminais de computadores. Estes últimos, em conjunção com o cada vez mais economicamente viável armazenamento em disco, facilitaram a interacção com os mainframes , até então feita com cartões perfurados. Quanto aos primeiros, eram suficientemente baratos para serem utilizados como computadores pessoais, tal como o MITS Altair ou o Apple II [4]. Ao surgirem no mercado aplicações financeiras para estas máquinas, elas começaram a ser utilizadas em pequenos escritórios, que antes não tinham poder económico para comprar um computador [6].

Paralelamente a esta evolução nos computadores, estava em desenvolvimento a ARPANet, uma rede de telecomunicações militar que precedeu a Internet, a tecnologia Ethernet (utilizada nas LANs) e o protocolo TCP/IP.

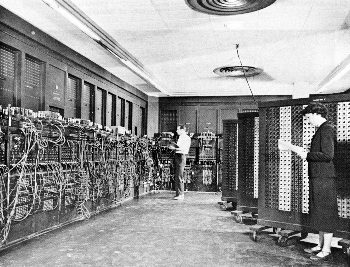

Ao longo dos anos 80 surgem computadores populares o IBM PC, o Apple Macintosh, o ZX Spectrum e o Commodore 64. Baseando-se na arquitectura aberta do IBM PC, surgem cada vez mais marcas no mercado com o seu computador pessoal “IBM PC compatible”, um termo que eventualmente caiu em desuso nos anos 90. Dá-se também uma evolução em termos gráficos e dos ecrãs monocromáticos dos anos 70 acaba-se a década nas 256 cores.

Quanto aos grandes computadores, os mainframes , estes começaram a perder mercado assim que as empresas repararam que podiam utilizar computadores menos complexos e mais baratos para executar as mesmas tarefas. Os terminais de antigamente também foram gradualmente sendo substituídos por PCs [11].

No domínio das redes, a ARPANet, agora sobre o protocolo TCP/IP, vai crescendo; ao longo dos anos aparecem novas redes que se ligam a esta tendo como fim a partilha de informação entre universidades e centros de pesquisa [10]. No final da década a rede de redes que se formou chama-se Internet e surgem os primeiros ISPs, providenciando acesso a serviços como e-mail ou newsgroups. Em 1989 surge a World Wide Web, um espaço de informação implementado sobre a Internet, recorrendo a um formato de documentos desenvolvido em meados dos anos 60, o hipertexto.

Figura 2 - O primeiro IBM PC, o modelo 5150 (fonte: Wikipedia)

Na década de 90 o mercado dos computadores pessoais massifica-se, em muito devendo-se ao lançamento das versões 3.1 e 95 do sistema operativo Windows. O hardware evolui de uma forma muito mais rápida que na década anterior e passa-se de um processador de 25 MHz (o Intel 486, produzido em 1989) para um com uma frequência de relógio 30 vezes mais maior, de 750 MHz (AMD Athlon) em 10 anos, ao contrário do que tinha sucedido nos anos 80, em que o aumento em velocidade se ficou pela ordem de 5 [8]. Nos dias que correm a velocidade de processamento já passou a barreira dos 4 GHz (4000 MHz). A miniaturização que se vinha verificando chegou ao ponto de os computadores caberem na palma da mão, como é o caso dos PDAs.

O desenvolvimento da World Wide Web continua e é introduzida a linguagem HTML em 1993. Nesta altura assiste-se a um boom nos acessos à Internet na ordem dos 300% (a ARPANet, entretanto, já tinha deixado de existir em 1990) [13]. Este crescimento vem trazer um novo ânimo ao mercado dos mainframes , agora utilizados como web servers [11].

O início

Como no início da evolução dos computadores estes pouco mais eram que máquinas de calcular gigantescas e ultra-rápidas, os seus usos não iam muito mais além que cálculos de balística ou simulações. No final anos 50, como aparecimento dos transístores e o “encolhimento” dos computadores, tornou-se menos dispendioso adquirir uma destas máquinas e não eram só organizações estatais e universidades que os possuíam, mas também bancos e fábricas, principalmente para contabilidade e inventário [3].

Aquele que é considerado o primeiro computador para fins comerciais, o LEO, foi usado para a “elaboração da lista de encomendas diárias” e para calcular “as necessidades de produção, instruções de montagem, horários de entrega, contas internas, custos e relatórios de gestão” [14]. O contributo destas máquinas para a empresa era, portanto, de aumentar a eficiência dalguns processos e/ou reduzir custos [15].

Apesar desta utilidade, a uso destes não era o mais simples: apesar de agora já não ser necessário mudar as ligações do computador para executar um programa diferente, usar cartões perfurados ou fitas magnéticas para introduzir dados não era uma tarefa que qualquer pudesse fazer. Isto estava reservado a quem soubesse trabalhar com um computador, expressão essa que tinha um significado completamente diferente do corrente: nesta altura era necessário saber como é que se programava um computador para correr um determinado programa, ao contrário do que acontece hoje. Assim, apenas os funcionários dos departamentos de informática da empresa, profissionais desta área, eram autorizados a aproximarem-se dos computadores, que nesta altura ainda ocupavam uma ou várias salas [16].

Para a operação destes departamentos, uma empresa média tinha entre 13 a 17 funcionários [18]:

• Operação do sistema : 3/4 pessoas

• Análise de sistemas : 2/3 analistas funcionais (pessoas mais ligadas aos processo de negócio), 2/3 analistas orgânicos (ponte de ligação entre os analistas funcionais e os programadores);

• Programação : 4/5 programadores;

• Gravação : 2/3 gravadores de dados;

• Chefia : 1 responsável do departamento, 1 responsável tecnológico.

A interacção dos demais com estas máquinas consistia apenas na requisição dos serviços [16]. Os papéis com os dados eram entregues aos operadores, estes introduziam-nos no computador durante o dia e o processamento dos dados era efectuado pela noite dentro [18].

Como nem todas as empresas podiam suportar os custos de toda esta estrutura, surgiram os Centros de processamento de dados (CPD). Estes ou processavam os dados pela empresa ou forneciam pessoal técnico para “análise, desenvolvimento e/ou manutenção dos programas informáticos existentes”, chegando mesmo a suportar a “gestão integral do próprio sistema do cliente” [18].

Não é claro se o ROI (Return On Investment – retorno do investimento) dos computadores desta altura era o mais favorável. Tendo em conta que os standards eram poucos e que as arquitecturas eram proprietárias, a escalabilidade destes era limitada ao que era oferecido pelo fabricante, excluindo os periféricos. Os programas tinham de ser feitos para a máquina em questão, portanto era pouco provável que estes pudessem ser reutilizados noutros computadores. Mas também era igualmente pouco provável que fosse adquirido outro computador para substituir o antigo, tendo em conta o custo destes, a sua durabilidade (a British Telecom teve computadores LEO em funcionamento até 1981 [14]) e a complexidade das tarefas executadas.

Maturação

Nos anos 70 o aparecimento dos terminais veio simplificar bastante a interacção do pessoal das empresas com os computadores centrais. Isto era conseguido com o uso de um modo de time-sharing , um conceito de partilha de tempo de processador por vários utilizadores. Mais tarde, com os microcomputadores, esta interacção foi reduzida ou mesmo eliminada [11].

Assim, a partir de agora já não era preciso ser um entendido no assunto para conseguir correr um programa, inserir ou visualizar dados. Estas tarefas deixaram de depender dos funcionários dos departamentos de informática, estando agora ao alcance de qualquer um com uma destas máquinas na secretária. Houve portanto um reforço da independência do indivíduo [15] e uma descentralização de processos [18].

A introdução de LANs nas empresas também começou nesta época, ajudada pelo desenvolvimento da tecnologia Ethernet. Ao longo dos anos 70 e 80, com a ajuda da expansão do mercado dos PCs elas ajudaram ao desenvolvimento da informatização das empresas [18]. Apesar disso estas redes eram, no geral, departamentais e eram quase exclusivamente focadas em processos internos [2]. Elas também levaram mais tarde ao aparecimento de, como é referido em [18], “ilhas de informação”, espaços gerados devido à não interligação das LANs compostos por bases de dados com informação redundante ou estruturas diferentes para o mesmo tipo de dados. Esta situação gerava problemas de falta de coerência e continuou pela década de 80 adentro até que no início dos anos 90 se começou a fazer a interligação de todos os departamentos [18].

Também é por esta altura que surgem os primeiros sistemas de informação (SI) configuráveis para as necessidades da empresa. Até então estes funcionavam apenas como SI de gestão, utilizados para gerar relatórios periódicos (como o LEO) [17]. Agora passavam a ser sistemas de apoio à decisão, ferramentas de simulação e análise capazes de ajudar os gestores a fazer o planeamento estratégico e financeiro. Mas os computadores da altura não tinham ainda o poder gráfico ou de processamento para aplicações espaciais (ferramentas que utilizam volumes muito grandes de dados location-specific , comuns nas bases de dados de agora [mais sobre este assunto aqui ]) [19].

No início dos anos 80 aparece então o PC. O facto de ser barato e de a oferta ser bastante grande, virtude da sua arquitectura aberta, permite a informatização das empresas mais pequenas. Estas deixam de estar dependentes dos CPD externos para o processamento dos dados [18]. As empresas maiores começam a substituir os terminais por estas máquinas e o mercado dos mainframes sofre com isto: eles continuam lá, mas o número de novas instalações decresce drasticamente [11] e eles são relegados para “tarefas de gestão e consolidação legacy ” [18].

Com todos estes desenvolvimentos, o que é que sobrava então para os departamentos de TI? Já não eram necessários para o processamento dos dados: os que antes requisitavam esses serviços podiam fazê-lo na sua secretária. Estariam então relegados para tarefas de manutenção e de administração de redes? Não. A sua importância no seio da empresa cresceu na medida em que todas as decisões em termos de tecnologia a utilizar passavam por eles [15]. A crescente utilização dos SI veio também reforçá-la (e criou os departamentos de SI), já que estes têm de ser adaptados às necessidades e estrutura da empresa, o que pode levar meses, e os processos e estratégias desta podem ser modificados com base nestes sistemas [18].

No seu artigo “Why Technologists Must Learn To Speak Business” [20], Matthew Moran escreve que a tecnologia não é “uma panaceia de oportunidade e crescimento”, mas sim algo que tem como objectivo disponibilizar informação à organização, algo que seja útil para o resto dos trabalhadores nas suas tarefas diárias, ou ferramentas que permitam aos gestores analisarem e planearem o rumo da empresa. É neste modelo que encaixa a estrutura dos departamentos de TI que se começa a formar.

A estrutura destes departamentos evoluiu da referida anteriormente para uma mais orientada para os processos de negócio da empresa. Se antes tínhamos mais pessoal com competências técnicas, agora passávamos também a ter pessoal com especializações na área desses processos, e gente que faz a ligação entre os dois mundos, como os Analistas de Negócio. Os departamentos de TI ganhavam assim uma organização mais vocacionada para a integração das tecnologias da informação com a vertente de criação de valor da empresa [15 e 18].

Esta organização depende do tipo de serviços que a empresa oferece e também da maneira como a própria empresa está organizada. Um modelo mais generalista proposto em [18] consiste numa divisão em 3 grupos: o grupo de Sistemas Operacionais, o grupo de Sistemas de Suporte à Decisão e o de Infra-estrutura & Service Desk.

- Sistemas Operacionais :

Este grupo é o que está orientado para dar apoio aos processos de funcionamento da empresa. Para tal é feita a sua divisão em 3 secções: Costumer & Consumer Management , Supply Chain e Information Management . A primeira é responsável pela interacção com as áreas da empresa que respondem junto dos clientes e consumidores, tais como marketing e departamento de vendas. A secção de Supply Chain está vocacionada para responder aos departamentos que fazem parte da Cadeia da Valor da empresa, desde logística e compras ao planeamento. A última dá resposta às secções financeiras, como contabilidade, tesouraria ou Recursos Humanos.

- Sistemas de Suporte à Decisão :

Este grupo, ao contrário do anterior, é o que está orientado para a tecnologia. A sua estrutura é a mesma que o grupo anterior, mas o foco é na tecnologia de suporte aos processos e não nos processos em si. É neste cenário que entra o Analista de Negócio referido anteriormente, para fazer a ligação entre estes 2 grupos. Este pode tanto ser o responsável tecnológico do departamento – que teria portanto que alargar as suas competências – como alguém mais ligado a outras áreas da empresa.

- Infra-estrutura & Service Desk :

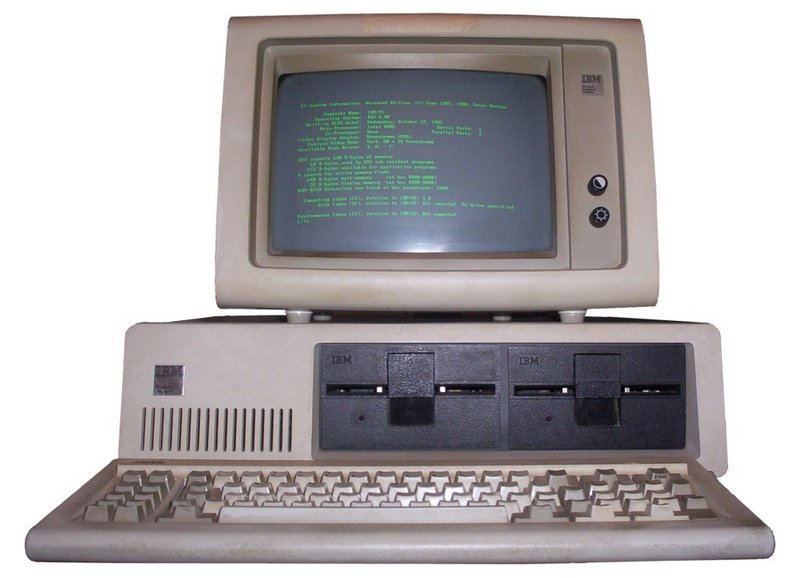

A figura seguinte mostra uma configuração da secção de Infra-estrutura & Service Desk:

Figura 3 - Infrastructure & Service Desk Organisation [18]

Como é possível ver na figura, ao contrário dos outros 2 grupos este não está orientado somente para os SI e corresponde mais à ideia normal de um departamento informático, ou seja:

• Administração de sistemas : administração dos servidores (e-mail, sistemas de gestão e, mais tarde, web-servers ) e de todo o parque tecnológico da empresa;

• Gestão de redes : gestão das LANs e ligações a redes externas (como por exemplo a Internet, cujo acesso se generalizou mais tarde nos anos 80), segurança;

• Apoio técnico : interface mais comum entre o departamento e o resto da empresa, composto por pessoal com formação técnica nas ferramentas utilizadas pelos funcionários da empresa.

Toda esta estrutura depende depois do CIO ou Chief Information Officer, aquele que vai determinar a utilização da tecnologia como ferramenta de suporte, e do CTO ou Chief Technology Officer, o gestor das infra-estruturas das TI. O CTO responde ao CIO, que responde por sua vezperante o CEO (Chief Executive Officer – o gestor máximo da empresa) [18].

A última década…

Figura 4 – Eles andam aí… (fonte: http://www.os390-mvs.freesurf.fr/mainfun.htm )

A notícia da morte dos mainframes foi largamente exagerada. Como foi dito anteriormente, o mercado de vendas tinha estagnado: o número de vendas caiu; os mainframes continuavam a ser utilizados e a prestar serviços à empresa, correndo aplicações feitas à 10 anos ou mais (mas que continuavam a ser úteis), mas a tendência eram os PCs. O desenvolvimento das redes e o boom nos acessos à Internet depois do aparecimento da World Wide Web deu um novo fôlego ao mercado, surgindo então a disposição nas empresas para os usar como web-servers . Porquê? Porque estas máquinas oferecem uma capacidade de vários computadores mais pequenos, mas a um preço de manutenção menor, com menor custo de energia e com uma administração mais simples [11].

Estes desenvolvimentos melhoraram as LANs empresariais, interligando o que antes eram as “ilhas de informação” referidas anteriormente. Esta interligação trouxe problemas à implementação de sistemas distribuídos de informação devido à falta de coerência dos dados nos departamentos. Esta situação foi resolvida com recurso aos sistemas abertos (sistemas não-proprietários, como as várias versões livres do UNIX), que facilitam a interoperabilidade e a partilha de recursos, permitindo a introdução de pacotes de gestão ERP (Enterprise Resource Planning) como o SAP, Oracle ou Peoplesoft (entretanto adquirida pela Oracle) [18]. Estas ferramentas são constituídas por módulos (Recursos Humanos, Logística, Contabilidade, etc.) que podem ser adquiridos separadamente e adaptados às necessidades da empresa. Como é dito em [2], elas representam um esforço das empresas em “estandardizar os processos chave” destas, algo que claramente não era conseguido antes.

Isto apresenta um esforço grande do lado dos departamentos de TI das empresas. Estes programas têm de substituir os sistemas de gestão anteriores, ou funcionar ao lado destes quando essa substituição não era possível ou desejada [mais sobre este assunto aqui ]. De uma maneira ou de outra têm de ser identificados os requisitos para os ERPs, partindo de uma análise estratégica da organização, feita por este departamento em conjunto com a gestão. A adaptação dos módulos aos processos internos e à estratégia também pode ser feita pelos profissionais da empresa, mas o mais comum é ser feita em conjunto com a empresa fornecedora.

No caso dos ERPs serem utilizados em conjunto com os sistemas anteriores, também denominados legacy ou legado, é necessário fazer o encapsulamento destes. Isto quer dizer que o programa não se apercebe de que está a comunicar com outro; os dados são-lhe fornecidos e ele devolve os resultados, tal como se estivesse a comunicar com um utilizador normal.

Este conceito evolui mais tarde para os web-services . Estes permitem a troca de dados entre aplicações, qualquer que seja a linguagem de programação ou plataforma em que estas funcionem, sobre uma rede.

São portanto as redes o grande motor de desenvolvimento do final desta época. A informação passa a fluir instantaneamente de um local para o outro dentro das organizações. Surgem as empresas baseadas na Internet, das quais a Amazon e a Google são exemplos de sucesso, e uns outros milhares são exemplo de fracasso perto do final do século. O conceito de eBusiness começa a aparecer na cabeça dos gestores das empresas. O mercado alarga-se ao mundo inteiro.

…e a próxima

Como foi possível notar no ponto anterior, a evolução das tecnologias e das aplicações obrigou os profissionais das TI a adaptarem-se rapidamente às necessidades e desafios que estas provocaram nas empresas. Mas, à medida que estas ganham uma maior dependência das TI, quais são os desafios que se colocam para o futuro?

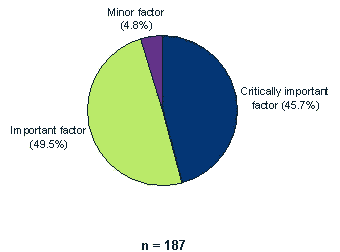

Figura 1 – Valor estratégico das TI nas empresas europeias em 2005

(fonte: http://www.idc.com/itforumblog/it_forum05_blog.html )

Várias fontes [18, 20, 21, 22, 23] apontam no sentido de que estes profissionais sejam menos técnicos e tenham uma maior ligação ao negócio, principalmente porque a tecnologia ganhou uma importância por vezes crítica para as organizações (como é possível ver na figura 5), mas é fundamental que quem a implementa e gere saiba providenciar as soluções de gestão correctas. A história seguinte, retirada de [20] ilustra bem a situação:

“While serving as CIO for a company we went through a phone system conversion. This involved several meetings with a variety of vendors. Three telephone system vendors did presentations. Two of the vendors spent an hour each talking exclusively about their product. They covered a myriad of features, including several we didn't care about. Only one vendor asked us to explain our business. He spent his time asking and analyzing how we used our current phone system, what features we were looking for, what we wanted to accomplish. His onsite analysis led to a better understanding of our business. He was able to pro-actively show us features that fit our business, including additional features we had not thought about. He offered suggestions on how these additional features might fit our business. Many were good ideas. In practice he became a consultant, not a salesman, and he won the deal.” |

Os profissionais do sector entendem esta evolução como natural [21], já que é algo que já tem vindo a acontecer desde a que os SI começaram a assumir alguma importância dentro das empresas. Muitos gestores e consultores começaram aliás como programadores, subindo na hierarquia da empresa à medida que foram ganhando experiência.

Um outro desenvolvimento que é previsto [22 e 23] pela Gartner, uma empresa de consultadoria, implica uma reestruturação dos departamentos e a eliminação de um em cada dez até 2011. Tal deve-se ao que foi referido nos parágrafos anteriores, da crescente orientação para o negócio dos profissionais – e, consequentemente, dos departamentos – e ao crescimento do outsourcing , que será responsável, segundo a mesma fonte, por menos 20% de pessoal nos departamentos de TI e menos 40% de pessoal técnico no total da empresa.

Conclusões

As TI andaram um longo caminho até chegarem onde estão hoje. E as organizações também tiveram de percorrer um caminho igualmente longo até a integração com as TI chegar ao ponto em que se encontra. A tecnologia passou a fazer parte integral dos processos de negócio e do planeamento do rumo das empresas, não “porque sim”, mas “porque é preciso”. A agilidade dos processos internos é maior se for utilizado um sistema que permita aos funcionários partilharem informação instantaneamente; a análise do funcionamento da empresa e o planeamento financeiro são mais fáceis se os gestores tiverem dados tratados em que possam basear as suas decisões.

É neste aspecto que entram os departamentos de TI, a fazer a ponte entre a tecnologia e os objectivos da organização. A sua estrutura evoluiu, as competências dos seus funcionários mudaram, o seu papel sofreu mudanças, mas a sua importância cresceu e vai continuar a crescer com o tempo.

Pretendia-se que o artigo mostrasse como foi a evolução dos departamentos de TI e como é que a sua importância se foi modificando ao longo do tempo. Pensa-se que tal ficou demonstrado nas várias secções do documento e que este contém referências importantes deste desenvolvimento. A relevância destes departamentos ficou bem patente ao longo do artigo, bem como as mudanças que estes foram sofrendo na sua estrutura e composição. Não se pretende, no entanto, glorificar estas divisões em relação às outras áreas das empresas. Por mais importantes ou críticos que os departamentos de TI possam ser dentro de uma empresa, estes continuam a ser de secções de suporte aos restantes departamentos e funcionários.

Referências

- Cunha, Paulo Rupino (2001), COMPLEMENTOS SISTEMAS DE INFORMAÇÃO CAP I – Evolução histórica dos sistemas de informação e dos departamentos de informática .

- Brown, Tony M., The Rise of Inclusive Computing, http://www.bijonline.com/Article.asp?ArticleID=292&DepartmentId=1.

- Meyers, Jeremy, A Short History of the Computer, http://www.softlord.com/comp/.

- Hoyle, Michelle A., Computers : From the Past to the Present , http://www.eingang.org/Lecture/index.html

- Wikipedia, Eniac , http://en.wikipedia.org/wiki/Eniac.

- Wikipedia, Microcomputer , http://en.wikipedia.org/wiki/Microcomputer .

- Wikipedia, Timeline of computing 1950-1979 , http://en.wikipedia.org/wiki/Timeline_of_computing_1950-1979 .

- Wikipedia, Timeline of computing 1980-1989 , http://en.wikipedia.org/wiki/Timeline_of_computing_1980-1989 .

- Wikipedia, Timeline of computing 1990-forward , http://en.wikipedia.org/wiki/Timeline_of_computing_1990-forward .

- Wikipedia, Internet , http://en.wikipedia.org/wiki/Internet

- Wikipedia, Mainframe computer , http://en.wikipedia.org/wiki/Mainframe_computer .

- White, Stephen, A Brief History of Computing , http://trillian.randomstuff.org.uk/~stephen//history.html

- Zakon, Robert H., Hobbes' Internet Timeline v8.1 , http://www.zakon.org/robert/internet/timeline/

- Wikipedia, LEO Computer, http://en.wikipedia.org/wiki/Leo_Computers

- Albino, João Pedro e Cunha, Maria Alexandra V. C., Administração de Informática - O que é Importante ? http://www.pr.gov.br/batebyte/edicoes/1996/bb51/adm.htm

- Museu do Computador, A história das máquinas mais importantes , http://www.museudocomputador.com.br/hist_histbrasil.php

- Wikipedia, Managment information system , http://en.wikipedia.org/wiki/Information_Systems

- Bach, Santiago Olmedo (2001), A Gestão dos Sistemas de Informação , 1ª Ed., Centro Atlântico Lda., Lisboa, 2001

- Power, D. J., A Brief History of Decision Support Systems , http://dssresources.com/history/dsshistory.html

- Moran, Matthew, Why Technologists Must Learn To Speak Business , http://www.cbtoolkit.com/consult/whytechnspeakbusiness.htm

- vários, Where is IT Going In The Next 5 Years Forum: Question for guys who are in IT for 10+ years , http://www.tek-tips.com/viewthread.cfm?qid=908668&page=1

- Pavani, Luana, A área de TI vai mudar , http://cio.uol.com.br/estrategias/2005/10/28/idgnoticia.2005-10-28.1252632055/IDGNoticia_view

- McCue, Andy, One in 10 IT departments will be scrapped by 2011, http://management.silicon.com/itdirector/0,39024673,39153449,00.htm